本文最后更新于:2024年7月25日 下午

概述

书接上回:《Rancher 系列文章 - Rancher 升级》, 我们提到:将 Rancher 用 Helm 从 v2.6.3 升级到 v2.6.4.

接下来开始进行 K3S 集群的升级:将 K3S 集群从 v1.21.7+k3s1 升级到 v1.22.5+k3s2

相关信息

本次升级的 K3S 集群的基本信息为:

- 天翼云上用 4 台机器安装的一个 1 master(及 etcd) 3 node 的 K3S 集群

- 其实… 这个 K3S 集群使用 k3s-ansible 脚本批量安装的。…

- K3S v1.21.7+k3s1

- Rancher 刚升级到 v2.6.4, 验证没啥大问题

- K3S 集群有用到 Traefik 管理 Ingress

- K3S 集群使用嵌入式 etcd 数据存储

升级方式评估

官方 提供了以下几种升级方式:

- 基础升级

- 使用安装脚本升级 K3s

- 使用二进制文件手动升级 K3s

- 自动升级

- 使用 Rancher 来升级 K3s 集群

- 使用 system-upgrad-controller 来管理 K3s 集群升级

我大概都过了一下,先说 Pass 的原因:

使用 Rancher 来升级 K3s 集群 - 🙅♂️

详细的文档在这里:升级 Kubernetes 版本 | Rancher | Rancher 文档

原文如下:

📚️ Quote:

先决条件:

- 从全局视图中,找到要升级 Kubernetes 版本的集群。选择 省略号 > 编辑。

- 点开集群选项。

- 从 Kubernetes 版本下拉菜单中,选择要用于集群的 Kubernetes 版本。

- 单击保存。

结果: 集群开始升级 Kubernetes 版本。

但是,但是!我在我的 Rancher v2.6.4 上始终没找到 省略号 > 编辑 在哪里,😂😂😂

我猜可能是因为我看的中文文档只有 Rancher v2.5 的,而 Rancher v2.6 UI 又经过了很大的调整,所以找不到了。

另外,这种 Rancher 的 local 集群,而且还是 单 master 节点,我个人评估是无法实现自动升级的。

PAAS

使用 system-upgrad-controller 来管理 K3s 集群升级 - 🙅♂️

详细文档见这里:自动升级 | Rancher 文档

我试了一下,结果就是在我创建了 server-plan 后,提示我 server-plan 的 POD 无法进行调度,因为所有节点都不满足调度的条件。

我大概看了一下,调度的条件是要求在 master 节点上,同时我只有 1 个 master, 其在升级前已经设置为了 cordon: true, 导致冲突,升级无法进行。

也正是因为这个,所以我判断:

- 单 master 节点,是无法实现自动升级的,或者即使可以进行升级,风险也较大

PAAS

使用二进制文件手动升级 K3s - 🙅♂️

这个还行,步骤也很清晰明了,也正好可以在 k3s-ansible 脚本增加 upgrade.yml playbook 来实现。

但是… 近期没时间,先记下这个事吧,后面有时间再增加这个功能。

使用安装脚本升级 K3s - ✔️

虽然我不是用安装脚本安装的 K3s, 但是 k3s-ansible 脚本的逻辑基本上和官方的安装脚本是一样的,只是用的是 ansible 而已。个人评估后认为:只要确保使用相同的标志重新运行安装脚本即可从旧版本升级 K3s.

就决定是你啦 ✔️

升级步骤

〇、信息收集

registries.yaml

有配置 registries.yaml, 如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

| mirrors:

docker.io:

endpoint:

- "https://registry.cn-hangzhou.aliyuncs.com"

- "https://docker.mirrors.ustc.edu.cn"

configs:

'docker.io':

auth:

username: caseycui

password: <my-password>

'quay.io':

auth:

username: east4ming

password: <my-password>

|

但是位置没有动,还是 /etc/rancher/k3s/registries.yaml. 所以不会因此导致有额外的升级步骤。

K3s Server 和 Agent 其他配置

1

2

3

4

5

6

7

| ---

k3s_version: v1.21.7+k3s1

ansible_user: caseycui

systemd_dir: /etc/systemd/system

master_ip: "{{ hostvars[groups['master'][0]]['ansible_host'] | default(groups['master'][0]) }}"

extra_server_args: '--write-kubeconfig-mode "644" --cluster-init --disable-cloud-controller --tls-san <my-public-ip> --kube-apiserver-arg "feature-gates=EphemeralContainers=true" --kube-scheduler-arg "feature-gates=EphemeralContainers=true" --kube-apiserver-arg=default-watch-cache-size=1000 --kube-apiserver-arg=delete-collection-workers=10 --kube-apiserver-arg=event-ttl=30m --kube-apiserver-arg=max-mutating-requests-inflight=800 --kube-apiserver-arg=max-requests-inflight=1600 --etcd-expose-metrics=true'

extra_agent_args: ''

|

分析上面配置,就是多了一些 server 的安装配置参数而已,使用官方安装脚本时注意确保使用相同的标志重新运行安装脚本即可。

一、备份

使用 k3s etcd-snapshot 进行备份,如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

| # k3s etcd-snapshot

INFO[2022-05-05T17:10:01.884597095+08:00] Managed etcd cluster bootstrap already complete and initialized

W0505 17:10:02.477542 2431147 warnings.go:70] apiextensions.k8s.io/v1beta1 CustomResourceDefinition is deprecated in v1.16+, unavailable in v1.22+; use apiextensions.k8s.io/v1 CustomResourceDefinition

W0505 17:10:02.923819 2431147 warnings.go:70] apiextensions.k8s.io/v1beta1 CustomResourceDefinition is deprecated in v1.16+, unavailable in v1.22+; use apiextensions.k8s.io/v1 CustomResourceDefinition

W0505 17:10:03.398185 2431147 warnings.go:70] apiextensions.k8s.io/v1beta1 CustomResourceDefinition is deprecated in v1.16+, unavailable in v1.22+; use apiextensions.k8s.io/v1 CustomResourceDefinition

INFO[2022-05-05T17:10:03.687171696+08:00] Saving etcd snapshot to /var/lib/rancher/k3s/server/db/snapshots/on-demand-4azlmvglqkx7migt-0002-1651741803

{"level":"info","msg":"created temporary db file","path":"/var/lib/rancher/k3s/server/db/snapshots/on-demand-4azlmvglqkx7migt-0002-1651741803.part"}

{"level":"info","ts":"2022-05-05T17:10:03.693+0800","caller":"clientv3/maintenance.go:200","msg":"opened snapshot stream; downloading"}

{"level":"info","msg":"fetching snapshot","endpoint":"https://127.0.0.1:2379"}

{"level":"info","ts":"2022-05-05T17:10:14.841+0800","caller":"clientv3/maintenance.go:208","msg":"completed snapshot read; closing"}

{"level":"info","msg":"fetched snapshot","endpoint":"https://127.0.0.1:2379","size":"327 MB","took":"11.182733612s"}

{"level":"info","msg":"saved","path":"/var/lib/rancher/k3s/server/db/snapshots/on-demand-4azlmvglqkx7migt-0002-1651741803"}

INFO[2022-05-05T17:10:14.879646814+08:00] Saving current etcd snapshot set to k3s-etcd-snapshots ConfigMap

|

📝Notes:

也可以增加更多的参数以将数据备份到 s3 中。

之所以这次没选择,是因为集群的互联网带宽太小,备份到 s3 频繁中断所以放弃。

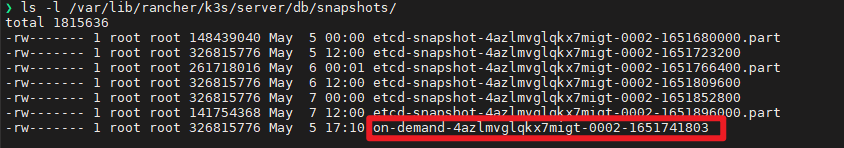

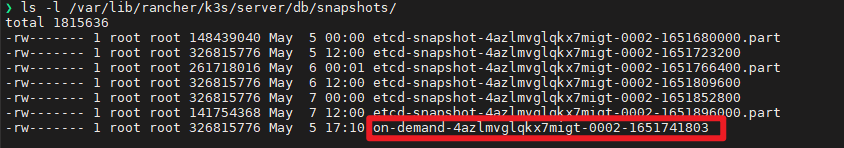

备份结果位于:/var/lib/rancher/k3s/server/db/snapshots/, 如下图:

二、k3s-killall.sh

为了保证升级成功率,且当前 K3s 集群主要用于测试和 Demo, 完全可以停机,所以使用 k3s-killall.sh 停止对应 node 后,再进行升级。

升级对应 node 前先执行如下命令:

1

| /usr/local/bin/k3s-killall.sh

|

三、使用安装脚本升级 server

🐾Notes:

要从旧版本升级 K3s,你可以使用相同的标志重新运行安装脚本

执行如下命令进行升级:

1

| curl -sfL https://rancher-mirror.rancher.cn/k3s/k3s-install.sh | INSTALL_K3S_VERSION=v1.22.5+k3s2 INSTALL_K3S_MIRROR=cn K3S_KUBECONFIG_MODE=644 sh -s - --cluster-init --disable-cloud-controller --tls-san <my-public-ip> --kube-apiserver-arg "feature-gates=EphemeralContainers=true" --kube-scheduler-arg "feature-gates=EphemeralContainers=true" --kube-apiserver-arg default-watch-cache-size=1000 --kube-apiserver-arg delete-collection-workers=10 --kube-apiserver-arg event-ttl=30m --kube-apiserver-arg max-mutating-requests-inflight=800 --kube-apiserver-arg max-requests-inflight=1600 --etcd-expose-metrics true

|

说明如下:

INSTALL_K3S_VERSION=v1.22.5+k3s2 升级的目标版本K3S_KUBECONFIG_MODE=644 ... --etcd-expose-metrics true 都是和之前的安装标志保持一致

升级成功,日志如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

| [INFO] Using v1.22.5+k3s2 as release

[INFO] Downloading hash https://rancher-mirror.rancher.cn/k3s/v1.22.5-k3s2/sha256sum-amd64.txt

[INFO] Downloading binary https://rancher-mirror.rancher.cn/k3s/v1.22.5-k3s2/k3s

[INFO] Verifying binary download

[INFO] Installing k3s to /usr/local/bin/k3s

[INFO] Skipping /usr/local/bin/kubectl symlink to k3s, already exists

[INFO] Skipping /usr/local/bin/crictl symlink to k3s, already exists

[INFO] Skipping /usr/local/bin/ctr symlink to k3s, already exists

[INFO] Creating killall script /usr/local/bin/k3s-killall.sh

[INFO] Creating uninstall script /usr/local/bin/k3s-uninstall.sh

[INFO] env: Creating environment file /etc/systemd/system/k3s.service.env

[INFO] systemd: Creating service file /etc/systemd/system/k3s.service

[INFO] systemd: Enabling k3s unit

Created symlink /etc/systemd/system/multi-user.target.wants/k3s.service → /etc/systemd/system/k3s.service.

[INFO] systemd: Starting k3s

|

四、使用安装脚本升级 Agent

🐾Notes:

要从旧版本升级 K3s,你可以使用相同的标志重新运行安装脚本

执行如下命令进行升级:

1

| curl -sfL https://rancher-mirror.rancher.cn/k3s/k3s-install.sh | INSTALL_K3S_VERSION=v1.22.5+k3s2 INSTALL_K3S_MIRROR=cn K3S_URL=https://<my-master-ip>:6443 K3S_TOKEN=<my-token> sh -s -

|

说明如下:

- 其他和 server 升级类似,主要就是版本和相同的标志

K3S_URL=https://<my-master-ip>:6443 K3S_TOKEN=<my-token> 这是作为 agent 安装需要的参数

K3S_TOKEN 位于:/var/lib/rancher/k3s/server/node-token, 该 token 升级前后没有发生变化

五、验证

验证可以通过一些 kubectl 命令,或图形化界面 Lens 或 K9S 或 Rancher 进行验证。

粗略看这些地方:

- Events: 有没有 Warning

- Node 状态:有没有异常的

- Pod 状态:有没有异常的

- Jobs 状态:有没有失败的

- Ingress 状态:有没有访问异常的

- PVC 状态:有没有非

Bound 状态的

kind: Addon status 有没有异常的

🎉🎉🎉

但是,验证过程中也发现几个问题,下面一一描述及解决:

📚️参考文档